加拿大傳播學者,同時也是媒介理論宗師的麥克魯漢曾說過,在判斷各種科技帶來的轉變與影響之前,我們需要先就其本身進行理解。唯有如此,我們才可能避免如白日夢遊般,被科技炫目的表象所惑。在面對今天經常被稱為「黑箱」的演算法時,這半世紀前的箴言仍十分受用。

本書的作者大衛.桑普特可以說正是在類似的動機下,企圖帶領讀者更清楚地理解究竟演算法做了什麼?在桑普特看來,老是要把演算法想成「黑箱」,或是比做生人勿近的武器,也許能提醒我們小心演算法的危害,但卻無法讓我們「理解」得更多。但唯有透過理解演算法,我們才可能避免成為演算法的俘虜。中譯本將本書中的 Outnumbered 譯為「數俘」,讀來因此也深具意味。

本書由三個部分組成,第一個部分討論演算法如何分析我們,第二個部分討論演算法如何影響我們,最後第三個部分則問,以演算法為基礎的 AI 是否將成為我們?三個部分分別探討了這幾年相當重要的幾個議題:劍橋分析事件、Facebook 的情緒實驗、為什麼川普會跌破眾人眼鏡當選、Facebook 是造就同溫層現象的罪魁禍首嗎、AI 有性別歧視嗎、AI 是否將成為人?

正閱讀著本文的你,也許會問:「這很多人談過了不是?」不,這本書也許跟你想的不一樣。我誠摯地建議你,跟我一起看下去。

演算法真的懂我嗎?

你大概曾經跟我有相似的經驗,上一秒正在跟朋友聊著假期該去哪裡玩,下一秒打開 Facebook 就發現相關旅遊去處的廣告。這時候我們通常會有兩種反應,一種是開心地想「哇!Facebook 真懂我!」,另一種則是「哇!Facebook 是不是在偷聽我說話!」。前者大概可以說是一種天真的樂觀主義者,後者則很像是某種科技恐懼的症狀。

但 Facebook 到底是真的懂我,還是偷偷竊聽我的壞蛋呢?桑普特指出,其實都不是。

Facebook 到底做了什麼?回到對於 Facebook 推薦廣告演算法的剖析,桑普特說明了這背後其實就是以所謂「主成分分析」方法運算出的結果。也就是說,Facebook 的演算法透過收集使用者所有的「按讚」之後,便可以建構出用以描繪使用者的數百個不同的維度,藉此來「了解」使用者。

這聽起來是不是相當神奇,所以 Facebook 真的懂我嗎?這個問題很重要,特別是如果你聽過「劍橋分析」這家公司的話。2018 年 3 月,一家名為「劍橋分析」的數據分析公司因不當取得大量 Facebook 用戶資料而登上新聞版面。但在此之前,這家公司可是因為宣稱川普的勝選都歸功於他們而聲名大噪。

在 2016 年的一場會議演講上,劍橋分析公司的執行長亞歷山大.尼克斯說,他們有辦法能夠「預測美國每一位成年人的人格」,進而針對不同人格特質的人投放不同的競選廣告。亞歷山大.尼克斯暗示,這就是川普勝選的秘密武器。

但是,Facebook 的演算法真的懂它的使用者,甚至還可以預測其人格特質嗎?藉由拆解劍橋分析公司的演算法,桑普特給出了否定的答案。其中討論的細節我想留給各位去閱讀,但我確實挺同意作者有點揶揄地將劍橋分析改名為「劍橋牛皮」(Cambridge Hyperbolytica)公司。如果稍微「劇透」一點的話,關鍵大概就在於:我們多大程度能將有某程度機率上的相關,看作是可預測的因果關係?

演算法是否真的能用來分析、弄懂一個人,還涉及另一個重要的議題,也就是:它是否能公平地評斷每一個人──特別是在一些攸關個人生存與生活處境的問題上?桑普特在此探討的案例,也是過去批評演算法的許多書裡曾討論過的,犯罪風險評估模型。但有別於僅是批評透過演算法來評估犯罪風險會有所偏誤,他更進一步說明了,其實關鍵在於,當我們要用演算法評估生存處境、條件、背景總是有差異的人群時,偏誤是不可能消除的。

換言之,我們不應抱持的是,「演算法必然公平」這種幻想。甚至,也許該反過來思考,如果演算法能夠更精準地判斷某一弱勢群體的風險狀態,即便犧牲一點對優勢群體判斷的準確性,這是否會是一種值得嘗試的作法?

Facebook 能操弄我?

劍橋公司是吹牛皮的,但 Google、Amazon、Facebook 這類平台可以透過演算法來影響、甚至操弄我們,總是真的了吧?近幾年,從川普勝選、英國脫歐等重大事件,甚至台灣社會過去經歷的幾次大選、公投,我們都看到了網路的過濾氣泡與同溫層效應如何導致嚴重的後果。然而,桑普特依然不輕率地如此認為,一切還得待我們理解其中的演算法後再下評判。

例如,大概很多人都曾聽過那惡名昭彰的「Facebook 情緒實驗」。不少人可能還可以說上兩句:Facebook 的資料科學家違反研究倫理,在未經用戶同意下進行動態消息的訊息操弄,進而影響了使用者。若先擱置研究倫理的問題,桑普特指出,當我們實際去看這篇論文便會發現,其實這個實驗結果顯示的是:操弄動態消息對用戶的情緒「幾乎沒有影響」。換言之,這又是另一個吹牛皮的實驗,這篇論文以〈經由社群網路進行大規模情緒感染的實驗證據〉這樣聳動的標題誤導了讀者。

談到這裡,你心中可能會想,所以這傢伙是要說演算法根本沒那麼厲害?或甚至覺得,他根本是在想方設法替演算法「脫罪」吧。不,雖然我也不見得全然同意作者的觀點,但回到作者撰寫本書的初衷,我相信重點是,如何透過理解演算法進而讓自己免於成為「數字的俘虜」。這裡所謂數字的俘虜,其實更廣義地說便是,不加反思地接受了演算法或隱或顯地餵給我們的資訊。

譬如說,大概比較「無關痛癢」的像是,你在網路書店上買了本書,然後就看到網頁下方顯示「其他買了這本書的人也買了……」,於是你又買了更多的書。我必須承認,對我而言有時這確實挺方便的。我想要找某個主題的書,與其大海撈針地從搜尋結果裡一本一本看,這種「推薦」可以讓我很快地知道其他人也買了哪些同一主題的書。桑普特把產生這類效果的演算法稱為「也喜歡」。他在書中建構了一套簡化版本的「也喜歡」演算法模型,並藉此說明這類演算法的問題。

問題在於,我以為其他人也跟我一樣仔細檢視後才買下某一主題的幾本「好書」,但實際上,「也喜歡」演算法的運算基礎根本不是「作品好壞」。更常見的情況反而是,某些書在一開始或隨機或因某些行銷手法被購買了,它就越可能成為被推薦的書籍,進而形成一種失控的回饋。於是,若我不檢視便購買了那些書,就等於讓自己成了桑普特所說的,掉進了演算法的「數俘」之中。

買錯書頂多是浪費錢,但如果接收到「錯誤資訊」呢?桑普特在書中也討論了近年來演算法操弄導致的「過濾泡泡」現象。今天,我們多半會認為 Facebook 這類社群媒體的演算法會導致過濾泡泡,進而形成今日人們憂心的同溫層現象。

但情況真的有如此嚴重嗎?桑普特一方面透過自己建構模型,另一方面也訪談了許多相關問題的研究者,得出的結論大略是這樣的:首先,Facebook 的演算法從簡化的模型來看,確實會形成過濾泡泡。但由於真實世界中使用者的「好友」實際上歧異性更大,因此過濾效應雖存在但並無想像中的嚴重。

最後,也是我認為桑普特的討論中最重要的一點是,如果你讓自己的生活完全「鎖」在社群媒體的泡泡中,而不再從傳統或其他媒體接收資訊,那麼,你就真的越可能被演算法的過濾泡泡所「數俘」。

AI 將要成為人?

在本書的最後一部分,問題也來到了近年來眾人矚目的焦點:以演算法為基礎的「人工智慧」(AI)是否將要成為人,甚或取代人?你現在大概猜得到桑普特的答案應該是否定的。他甚至主張,現今人工智慧的發展程度若與各種生物相比,大概只能說接近「肚子裡的壞菌」的層次而已。且不論這種比較是否令人信服,重點是,為什麼?AI 到底現在能做什麼、又做不到什麼?

桑普特的討論中有幾個對我而言特別有意義的例子。像是,AI 到底會不會有「性別歧視」這個問題。一方面,去年你可能跟我一樣也注意到一個新聞,微軟開發了一個聊天機器人,結果它竟然十足是個性別歧視者與種族主義者。另一方面,也有太多研究指出,像是 Google 搜尋有性別歧視、Amazon 透過 AI 檢視應徵者履歷時也有性別歧視。這到底是怎麼回事?按理來說,演算法不就「只是」數學運算嗎?為什麼會「像人一樣」不斷引發這類爭議?

桑普特的解釋簡單來說是這樣:與性別歧視相似的問題背後涉及了自然語言處理的演算法。他以史丹佛自然語言處理團隊開發的 GloVe 演算法為例說明運作過程。GloVe 在處理資料時,會將每個語詞置放在數百個維度空間的一個點上,藉此,每個語詞之間就會形成不同遠近距離的相對關係。換言之,我們要注意到,演算法不是真的「懂」語言,而只是在測量位於多維度空間中不同位置上的詞語之間的距離而已。

在訪談英國巴斯大學資訊科學家裘安娜時,桑普特總結的一句話我認為最具啟發性,他說:「演算法只是將我們的文化如何使用語詞量化而已」。這句話的意思是:有性別、種族以及各種歧視問題的,其實是我們人類自身。

因為這類自然語言處理的演算法,往往是透過所謂「非監督式學習」來進行訓練。也就是說,演算法在學習的過程中,不會有人去確認它學了些什麼並給予回饋。因此,只要我們的文化無法去除各種歧視,那麼演算法永遠都只能透過內嵌著歧視的文本資料進行學習,然後再複製整個歧視的結構。

這種只能「學習」資料內嵌的文化模式、價值與知識的演算法,恐怕很難說是「有智慧」的。桑普特接著也以文本創作、打電動為例繼續說明:演算法也許真的能展現出令人驚豔的能力,像是可以「寫小說」、可以打敗世界棋王等等,但是要說演算法已經「像人」一樣會做這些事,恐怕還言之過早。

一個關鍵的問題在於,桑普特主張,不管是由上而下設計的演算法,還是由下而上設計的演算法,只要演算法還無法像一般動物那樣,將自身已有的知識外推到其他現象上,那麼 AI 要成為人就還有一大段路要走。

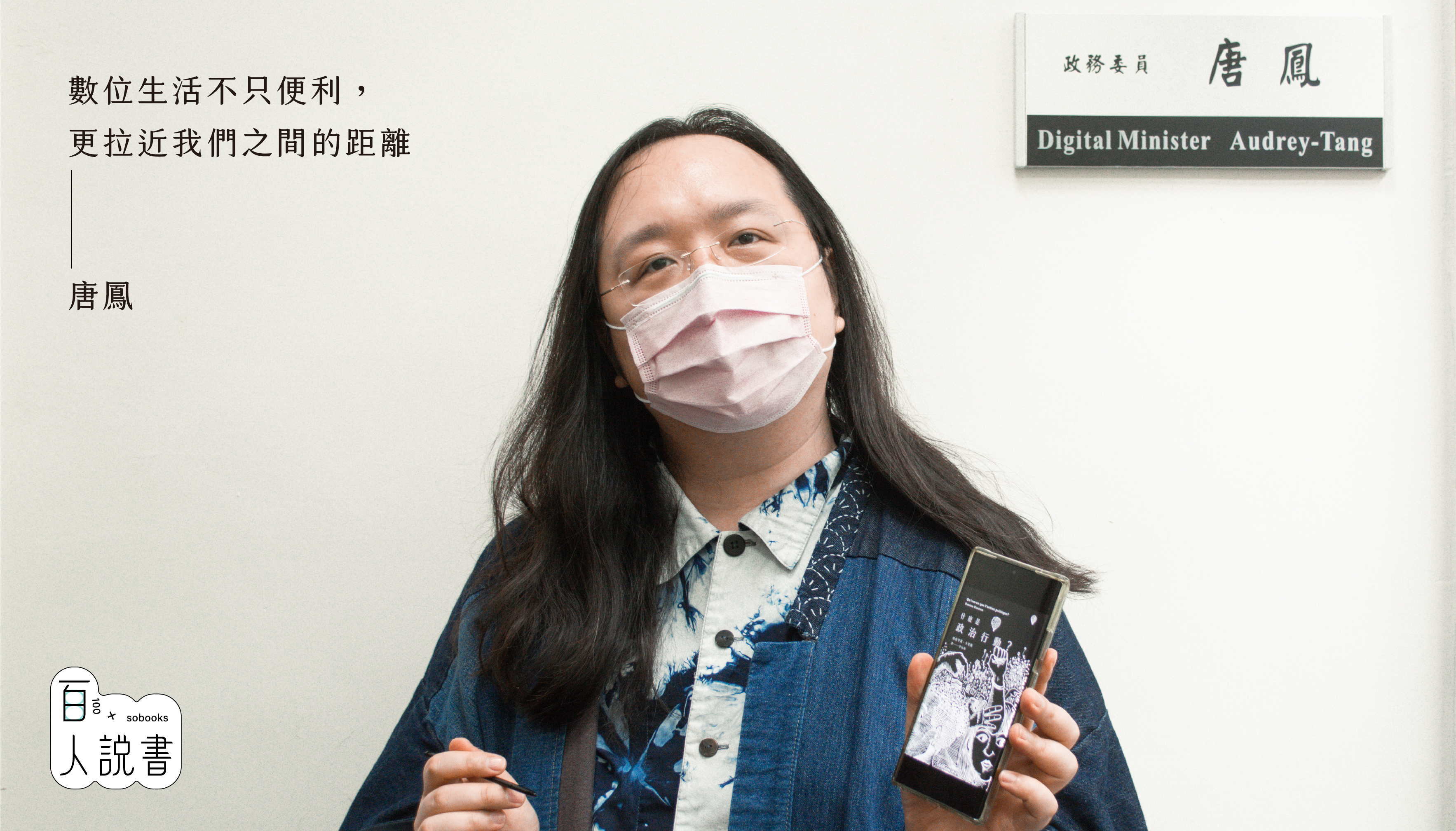

最後,要說我最認同桑普特這本書的一個觀點是什麼,那絕對是他引述英國萊斯特德蒙福特大學教授凱薩琳的這句話:「真正的威脅不在於電腦智能大幅提升,而是我們使用現有的工具只造福少數人,而非改善多數人的生活,只想著為超級富豪提供管家,而非解決廣大人民的問題」。作為社會學家,我深信演算法與 AI 不僅僅是科技議題,更是影響了我們生存與生活處境的社會議題。

(本文作者為世新大學社會心理學系助理教授)

演算法和操弄人心的恐慌正在蔓延,而本書作者帶領我們遍觀各種演算法,看見數學不為人知的一面。藉由訪問走在演算法研究最前端的科學家並自己做數學實驗分析佐證,作者除了解釋數學與統計如何運用於現實生活,也說明了現今社群演算法的能力與極限,讓我們更了解現今的網路服務是如何影響我們。